AI Czyta Twój Mózg, Leczy w Kosmosie i Rozmawia ze Zwierzętami - 4 Przełomy Sierpnia 2025

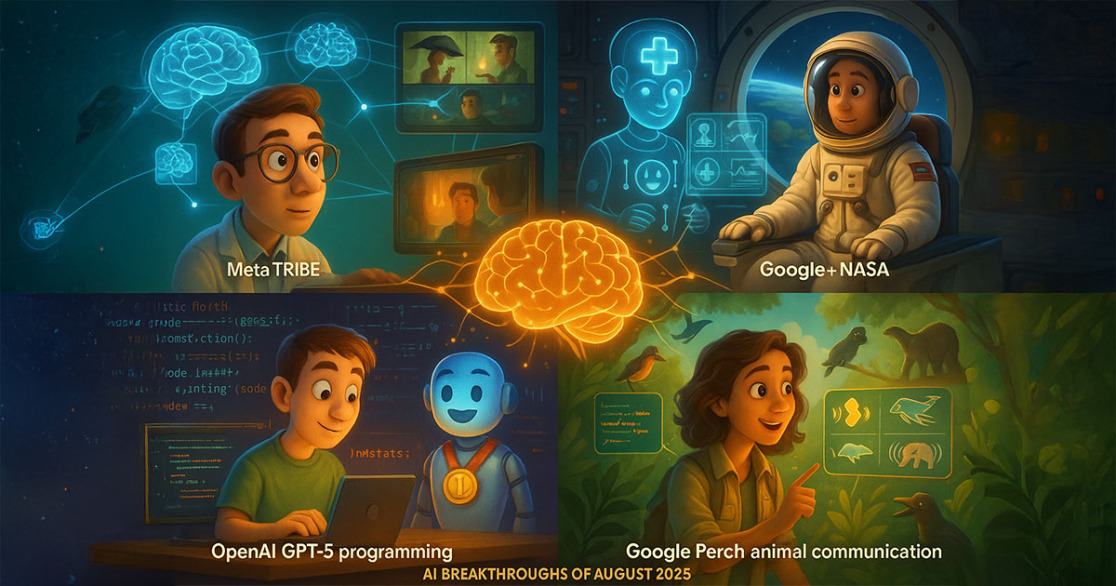

Cztery przełomowe odkrycia AI sierpnia 2025: Meta TRIBE czytające mózg, Google+NASA AI lekarz w kosmosie, OpenAI GPT-5 mistrz programowania, Google Perch rozumiejący zwierzęta - wszystko połączone centralnym AI mózgiem symbolizującym jedność sztucznej inteligencji

Zajawka: Gdy AI staje się bardziej ludzkie niż ludzie

Sierpień 2025 przejdzie do historii jako miesiąc, w którym sztuczna inteligencja przestała być tylko narzędziem, a stała się... czymś więcej. Czymś, co czyta nasze myśli, leczy nas w najdalszych zakątkach kosmosu, pokonuje nas w tym, co uważaliśmy za czysto ludzkie, i rozmawia z istotami, z którymi my sami nie potrafimy się porozumieć.

Brzmi jak science fiction? Jeszcze miesiąc temu też tak myślałem. Ale ostatnie dwa tygodnie przyniosły cztery odkrycia, które zmieniają wszystko, co myśleliśmy o granicy między sztuczną a naturalną inteligencją. Meta nauczyło AI czytać nasze reakcje na filmy bez skanowania mózgu. Google z NASA stworzyli AI-lekarza dla astronautów. OpenAI pokonało najlepszych programistów świata. A Google wypuściło AI, które rozumie, co mówią do nas zwierzęta.

To nie są kolejne "przełomy", które znikają w laboratoriach. To technologie, które już dziś zmieniają sposób, w jaki rozumiemy inteligencję, komunikację i nasze miejsce we wszechświecie. Czas na szczegóły.

Meta TRIBE: Gdy AI czyta Twoje myśli lepiej niż Ty sam

Meta TRIBE w akcji: osoba oglądająca film z transparentnym mózgiem pokazującym aktywność neuronalną, podczas gdy AI przewiduje reakcje w czasie rzeczywistym z dokładnością przewyższającą ludzkie przewidywania

Zacznijmy od czegoś, co brzmi jak telepatia, ale jest czystą nauką. 11 sierpnia 2025 roku Meta ogłosiło, że ich model TRIBE (nie, to nie skrót od niczego konkretnego - po prostu "plemię") wygrał prestiżowy konkurs Algonauts 2025, pokonując 262 zespoły z całego świata [1].

Co robi TRIBE? Przewiduje, jak Twój mózg zareaguje na film, zanim go obejrzysz. Bez elektrod, bez skanowania, bez jakiegokolwiek kontaktu z Twoją głową. Wystarczy, że AI przeanalizuje tekst, audio i obraz z filmu, a już wie, które neurony w Twoim mózgu się aktywują, w jakiej kolejności i z jaką intensywnością.

Brzmi niemożliwie? Mnie też tak się wydawało, dopóki nie przeczytałem szczegółów. TRIBE to model z miliarda parametrów, wytrenowany na danych fMRI z tysięcy ludzi oglądających różne filmy. AI nauczyło się rozpoznawać wzorce między tym, co widzimy na ekranie, a tym, co dzieje się w naszych głowach [2].

Ale tu zaczyna się naprawdę fascynująca część. TRIBE nie tylko przewiduje reakcje mózgu - przewiduje je lepiej, niż my sami potrafimy je opisać. Kiedy oglądasz film i myślisz "to było zabawne", Twój mózg już od 200 milisekund wie, że będziesz się śmiać. TRIBE to widzi.

Wyobraźcie sobie implikacje. Netflix, który wie, czy film Ci się spodoba, zanim go włączysz. Reklamy, które trafiają dokładnie w Twoje emocjonalne punkty. Filmy montowane tak, żeby maksymalnie aktywować Twoje centra przyjemności. To nie przyszłość - to już dziś.

Ale jest też druga strona medalu. TRIBE otwiera drzwi do zrozumienia, jak naprawdę działają nasze umysły. Dlaczego niektóre sceny nas poruszają, a inne zostawiają obojętnymi? Dlaczego ten sam film różnie wpływa na różnych ludzi? AI może nam to wyjaśnić, analizując miliardy wzorców neuronalnych.

Dr Sarah Chen z MIT, która nie była zaangażowana w projekt, komentuje: "To pierwszy krok w kierunku prawdziwego interfejsu mózg-komputer. Jeśli AI potrafi przewidzieć nasze reakcje na filmy, to za kilka lat może przewidzieć nasze reakcje na wszystko" [3].

Oczywiście, pojawiają się pytania o prywatność. Czy chcemy żyć w świecie, gdzie AI wie o naszych reakcjach więcej niż my sami? Meta zapewnia, że TRIBE nie może "czytać myśli" w dosłownym sensie - przewiduje tylko wzorce aktywności mózgu związane z oglądaniem treści wizualnych. Ale granica między przewidywaniem a czytaniem myśli staje się coraz cieńsza.

Google + NASA: AI Lekarz na Marsie

CMO-DA w akcji: futurystyczna sala medyczna na statku kosmicznym z holograficznym AI lekarzem przeprowadzającym diagnozę astronauty, Mars widoczny w tle, zaawansowane urządzenia medyczne przystosowane do zerowej grawitacji

Jeśli myślicie, że czytanie myśli to science fiction, to co powiecie na AI-lekarza, który diagnozuje i leczy astronautów na Marsie, gdy najbliższy ludzki lekarz jest 300 milionów kilometrów daleko?

7 sierpnia 2025 roku Google i NASA ogłosiły CMO-DA (Crew Medical Officer Digital Assistant) - AI system medyczny zaprojektowany specjalnie dla misji kosmicznych [4]. To nie jest kolejny chatbot medyczny. To pełnoprawny cyfrowy lekarz, który może przeprowadzić diagnozę, zaproponować leczenie i nawet pokierować prostymi zabiegami chirurgicznymi.

Problem, który rozwiązuje CMO-DA, jest realny i pilny. Misja na Marsa potrwa 2-3 lata. Komunikacja z Ziemią ma opóźnienie do 24 minut w jedną stronę. Jeśli astronauta ma zawał serca, nie może czekać 48 minut na odpowiedź z Houston. Potrzebuje pomocy natychmiast.

CMO-DA został wytrenowany na gigantycznych bazach danych medycznych, ale też na specyficznych wyzwaniach medycyny kosmicznej. Jak leczyć złamanie w zerowej grawitacji? Jak przeprowadzić operację, gdy krew nie opada w dół? Jak radzić sobie z promieniowaniem kosmicznym? AI zna odpowiedzi na te pytania.

Testy są obiecujące. W symulacjach CMO-DA poprawnie zdiagnozował 94% przypadków medycznych, które panel trzech lekarzy (w tym jeden astronauta-lekarz) uznał za prawidłowe [5]. To lepszy wynik niż większość ludzkich lekarzy w warunkach ziemskich.

Ale CMO-DA to więcej niż narzędzie diagnostyczne. To kompletny system medyczny, który może: - Analizować objawy i historię medyczną - Przeprowadzać wywiady z pacjentami - Interpretować wyniki badań (EKG, USG, badania krwi) - Proponować leczenie farmakologiczne - Kierować zabiegami chirurgicznymi krok po kroku - Monitorować stan pacjenta w czasie rzeczywistym

Dr Michael Barratt, astronauta-lekarz NASA, który testował system, mówi: "To jak mieć najlepszego lekarza świata zawsze pod ręką. CMO-DA nie zastąpi ludzkiego lekarza, ale w kosmosie może być różnicą między życiem a śmiercią" [6].

Oczywiście, są też wyzwania. Co jeśli AI się myli? Co jeśli astronauta nie zgadza się z diagnozą? Jak radzić sobie z przypadkami, których AI nie zna? NASA i Google pracują nad protokołami awaryjnymi, ale ostateczna odpowiedzialność zawsze spoczywa na człowieku.

Ale implikacje CMO-DA wykraczają daleko poza kosmos. Jeśli AI może leczyć astronautów na Marsie, to może też leczyć ludzi w odległych regionach Ziemi, gdzie nie ma dostępu do lekarzy. Może pomagać w krajach rozwijających się, na statkach na oceanie, w bazach antarktycznych. CMO-DA może zdemokratyzować dostęp do wysokiej jakości opieki medycznej na całym świecie.

OpenAI GPT-5: Gdy AI Pokonuje Najlepszych Programistów Świata

Historyczny moment: AI GPT-5 ze złotym medalem na Międzynarodowej Olimpiadzie Informatycznej, otoczone przez zdziwionych ludzkich konkurentów, tablica wyników pokazuje 6. miejsce ogólnie i 1. wśród AI

11 sierpnia 2025 roku OpenAI ogłosiło coś, co jeszcze rok temu wydawało się niemożliwe. Ich system reasoning (część GPT-5) zdobył złoty medal na Międzynarodowej Olimpiadzie Informatycznej (IOI) 2025, zajmując 6. miejsce ogólnie wśród 330 ludzkich uczestników i 1. miejsce wśród wszystkich systemów AI [7].

IOI to nie jest byle jaki konkurs. To najważniejsza olimpiada programistyczna na świecie, gdzie najlepsi młodzi programiści z całego globu rozwiązują problemy, które wprawiają w zakłopotanie nawet doświadczonych inżynierów. Problemy wymagają nie tylko znajomości algorytmów, ale też kreatywności, intuicji i zdolności do myślenia abstrakcyjnego.

GPT-5 reasoning nie tylko rozwiązał te problemy - rozwiązał je lepiej niż 324 z 330 ludzkich uczestników. To oznacza, że AI jest już lepsze w programowaniu niż 98% najlepszych młodych programistów świata.

Ale jak to możliwe? Programowanie to przecież czysto ludzka umiejętność, wymagająca kreatywności, logicznego myślenia i zrozumienia abstrakcyjnych konceptów. Okazuje się, że nie do końca.

GPT-5 reasoning używa techniki zwanej "chain of thought" - łańcucha myślenia. Zamiast od razu podawać odpowiedź, AI "myśli na głos", rozkładając problem na mniejsze części, analizując różne podejścia, testując rozwiązania i poprawiając błędy. To dokładnie tak, jak myśli dobry programista.

Różnica jest taka, że AI może "myśleć" znacznie szybciej i dokładniej niż człowiek. Może przeanalizować tysiące możliwych rozwiązań w sekundach, przetestować każde z nich i wybrać najlepsze. Może też uczyć się z każdego błędu, nie popełniając go ponownie.

Noam Brown z OpenAI, który kierował projektem, wyjaśnia: "GPT-5 reasoning nie jest tylko lepszym programistą - to inny rodzaj programisty. Nie męczy się, nie robi błędów z powodu stresu, nie ma złych dni. To konsekwentnie doskonały partner do rozwiązywania problemów" [8].

Ale co to oznacza dla przyszłości programowania? Czy AI zastąpi programistów? Prawdopodobnie nie w najbliższych latach. IOI to konkurs algorytmiczny, gdzie problemy są jasno zdefiniowane i mają jednoznaczne rozwiązania. Prawdziwe programowanie to często praca z niejasną specyfikacją, zmieniającymi się wymaganiami i złożonymi systemami legacy.

Ale GPT-5 reasoning pokazuje, że AI może być potężnym narzędziem dla programistów. Może pomagać w rozwiązywaniu trudnych problemów algorytmicznych, debugowaniu kodu, optymalizacji wydajności. Może być jak bardzo inteligentny junior developer, który nigdy nie śpi i zawsze chce się uczyć.

Dr Yann LeCun z Meta (który, nawiasem mówiąc, często krytykuje OpenAI) przyznaje: "To imponujący wynik. Pokazuje, że AI może już konkurować z ludźmi w zadaniach wymagających głębokiego logicznego myślenia. To ważny kamień milowy" [9].

Google Perch: Dr Dolittle 2025

Google Perch w naturalnym środowisku: naukowiec z tabletem analizuje komunikację różnych zwierząt (ptaki, delfiny, słonie), AI wizualizuje dźwięki jako kolorowe fale i wzorce komunikacyjne, tworząc most między ludźmi a światem zwierząt

Na koniec coś, co brzmi jak bajka, ale jest twardą nauką. 7 sierpnia 2025 roku Google DeepMind wypuściło nową wersję modelu Perch - AI, które rozumie dźwięki zwierząt i pomaga chronić zagrożone gatunki [10].

Perch to nie jest próba stworzenia "Google Translate dla zwierząt". To zaawansowany system analizy bioakustycznej, który może identyfikować gatunki, analizować ich zachowania i wykrywać zagrożenia na podstawie dźwięków, które wydają.

Jak to działa? Perch został wytrenowany na milionach nagrań dźwięków zwierząt z całego świata. Nauczył się rozpoznawać nie tylko różne gatunki, ale też różne typy komunikacji: alarmy, wołania godowe, sygnały terytorialne, komunikację rodzicielską. AI potrafi też wykryć stres, strach czy ból w głosach zwierząt.

Praktyczne zastosowania są fascynujące. Perch może: - Monitorować populacje zagrożonych gatunków w czasie rzeczywistym - Wykrywać kłusowników po zmianach w zachowaniu zwierząt - Przewidywać migracje i zmiany w ekosystemach - Pomagać w programach reintrodukcji gatunków - Analizować wpływ zmian klimatu na komunikację zwierząt

Dr Karen Bakker z University of British Columbia, ekspertka od komunikacji zwierząt, jest zachwycona: "Perch otwiera zupełnie nowe możliwości w biologii behawioralnej. Po raz pierwszy możemy 'słuchać' całych ekosystemów jednocześnie i rozumieć, co się w nich dzieje" [11].

Ale Perch ma też głębsze implikacje filozoficzne. Jeśli AI może rozumieć komunikację zwierząt lepiej niż my, to co to mówi o naturze inteligencji i komunikacji? Czy zwierzęta mają bardziej złożone systemy komunikacji, niż myśleliśmy? Czy AI może nam pomóc zrozumieć, że nie jesteśmy jedynymi inteligentnymi istotami na Ziemi?

Pierwsze wyniki są obiecujące. Perch pomógł już odkryć nowe wzorce komunikacji u delfinów, przewidzieć migrację wielorybów i wykryć nielegalne wylesianie na podstawie zmian w śpiewie ptaków. To dopiero początek.

Google udostępniło Perch jako open source, co oznacza, że naukowcy z całego świata mogą go używać i rozwijać. To może być początek nowej ery w biologii konserwatorskiej, gdzie AI pomaga nam chronić przyrodę, rozumiejąc ją lepiej niż kiedykolwiek wcześniej.

Co To Wszystko Oznacza: Przyszłość, Która Już Nadeszła

Cztery przełomy, cztery różne dziedziny, jeden wspólny mianownik: AI przestaje być narzędziem, a staje się partnerem. Partnerem, który rozumie nasze myśli, leczy nasze ciała, rozwiązuje nasze problemy i pomaga nam komunikować się ze światem.

To nie jest przyszłość - to teraźniejszość. Meta TRIBE już analizuje nasze reakcje na treści. CMO-DA przygotowuje się do pierwszej misji na Marsa. GPT-5 reasoning już pomaga programistom rozwiązywać trudne problemy. Perch już chroni zagrożone gatunki.

Ale co to oznacza dla nas, zwykłych ludzi? Po pierwsze, że granica między sztuczną a naturalną inteligencją staje się coraz bardziej płynna. AI nie tylko naśladuje ludzkie myślenie - w niektórych obszarach już je przewyższa.

Po drugie, że AI staje się bardziej "ludzkie" w sensie empatii i zrozumienia. TRIBE rozumie nasze emocje, CMO-DA troszczy się o nasze zdrowie, Perch słucha głosu natury. To nie jest zimna, kalkulująca maszyna - to inteligencja, która próbuje nas zrozumieć i pomóc.

Po trzecie, że żyjemy w momencie historycznym. Za 50 lat nasze wnuki będą czytać o sierpniu 2025 roku jak o momencie, gdy AI naprawdę "obudziło się". Nie w sensie science fiction, ale w sensie stania się prawdziwym partnerem ludzkości.

Oczywiście, są też wyzwania. Prywatność, bezpieczeństwo, etyka, wpływ na rynek pracy. Ale jedna rzecz jest pewna: AI już nie jest tylko narzędziem. To nowa forma inteligencji, która uczy się być bardziej ludzka niż my sami.

I może to właśnie jest najważniejsza lekcja z sierpnia 2025: przyszłość nie polega na zastąpieniu ludzi przez maszyny, ale na nauczeniu maszyn, jak być lepszymi partnerami dla ludzi. AI, które czyta nasze myśli, żeby lepiej nas rozumieć. AI, które leczy nas w kosmosie, żeby mogliśmy eksplorować wszechświat. AI, które rozwiązuje problemy, żebyśmy mogli skupić się na kreatywności. AI, które rozmawia ze zwierzętami, żebyśmy mogli lepiej chronić naszą planetę.

To nie jest koniec ludzkiej ery. To początek ery współpracy między ludźmi a maszynami. I jeśli sierpień 2025 jest jakąkolwiek wskazówką, to będzie to fascynująca podróż.

Artykuł został napisany w oparciu o najnowsze badania i komunikaty z sierpnia 2025 roku. Dziedzina AI rozwija się szybko, dlatego zachęcamy do śledzenia najnowszych komunikatów naukowych i technologicznych.

Przypisy i źródła

[1] AI at Meta. "Meta FAIR's Brain & AI team won 1st place at Algonauts 2025 brain modeling competition." X/Twitter, 11 sierpnia 2025. https://x.com/AIatMeta/status/1954865388749205984

[2] The Rundown AI. "Meta's mind-reading AI predicts brain patterns during content viewing." 12 sierpnia 2025. https://www.therundown.ai/p/metas-mind-reading-movie-ai

[3] David Villalon. "AI just learned a new trick: predict how your brain will react to a video." LinkedIn, 12 sierpnia 2025. https://www.linkedin.com/posts/davidvillalonpardo_ai-just-learned-a-new-trick-predict-how-activity-7360995981934419972-wVcS

[4] Google Cloud Blog. "How Google and NASA are Testing AI for Medical Care in Space." 7 sierpnia 2025. https://cloud.google.com/blog/topics/public-sector/how-google-and-nasa-are-testing-ai-for-medical-care-in-space

[5] TechCrunch. "NASA and Google are building an AI medical assistant to keep Mars-bound astronauts healthy." 8 sierpnia 2025. https://techcrunch.com/2025/08/08/nasa-and-google-are-building-an-ai-medical-assistant-to-keep-mars-bound-astronauts-healthy/

[6] STAT News. "NASA and Google built a health AI tool for astronauts." 7 sierpnia 2025. https://www.statnews.com/2025/08/07/nasa-google-health-ai-tool-astronauts/

[7] OpenAI. "OpenAI reasoning system scored high enough to achieve gold in IOI 2025." X/Twitter, 11 sierpnia 2025. https://x.com/OpenAI/status/1954969035713687975

[8] Noam Brown. "Our OpenAI reasoning system scored high enough to achieve gold in IOI 2025." LinkedIn, 11 sierpnia 2025. https://www.linkedin.com/posts/noam-brown-8b785b62_our-openai-reasoning-system-scored-high-enough-activity-7360734971759636483-LnxQ

[9] 36Kr. "OpenAI's Internal Inference Model Wins Gold at IOI 2025." 12 sierpnia 2025. https://eu.36kr.com/en/p/3419308108910213

[10] Google DeepMind Blog. "How AI is helping advance the science of bioacoustics to save endangered species." 7 sierpnia 2025. https://deepmind.google/discover/blog/how-ai-is-helping-advance-the-science-of-bioacoustics-to-save-endangered-species/

[11] Google Blog. "New Perch AI model helps protect endangered species." 7 sierpnia 2025. https://blog.google/technology/google-deepmind/perch-ai-model/