Lightricks LTX-V: Dlaczego ten generator wideo może zmienić wszystko (i dlaczego wcale nie musi)

Lightricks właśnie wypuścił LTX-V - pierwszy generator wideo AI, który używa architektury DiT zamiast przestarzałego U-Net. Brzmi nudno? Może. Ale efekt jest taki, że wideo generuje się szybciej niż Netflix ładuje następny odcinek. I nie, to nie przesada.

Zanim zaczniemy - o czym właściwie mówimy?

Nie da się ukryć - kolejny "przełomowy" model AI do generowania wideo. Brzmi znajomo? Pewnie tak. Ale zanim przewrócisz oczami i przejdziesz do następnego artykułu, daj mi pięć minut. LTX-V to coś więcej niż marketingowy szum.

Może zacznę od tego, co mnie zaskoczyło. Nie wielkość modelu (choć 13 miliardów parametrów robi wrażenie). Nie jakość wideo (choć 1216×704 przy 30 FPS to solidny standard). To szybkość. Wideo generuje się szybciej, niż potrzeba czasu na jego obejrzenie [1].

Brzmi jak science fiction? Też tak myślałem.

Co sprawia, że LTX-V jest... inny?

Większość generatorów wideo opiera się na architekturze U-Net. Sprawdzonej, ale... no właśnie. Sprawdzonej. Lightricks poszedł inną drogą - DiT, czyli Diffusion Transformer [1]. Nie będę udawał, że to rewolucja na miarę wynalezienia koła, ale różnica jest odczuwalna.

DiT lepiej radzi sobie z sekwencjami czasowymi. Proste? Może. Skuteczne? Zdecydowanie.

Ale żeby nie było - to nie jest model dla każdego. Potrzebujesz przynajmniej 8GB VRAM. Choć... właściwie to nie tak dużo, jak na dzisiejsze standardy. RTX 4060 Ti wystarcza. Nie każdy ma taką kartę, ale nie mówimy o sprzęcie z kosmosu.

Wersje modelu - bo wybór to podstawa

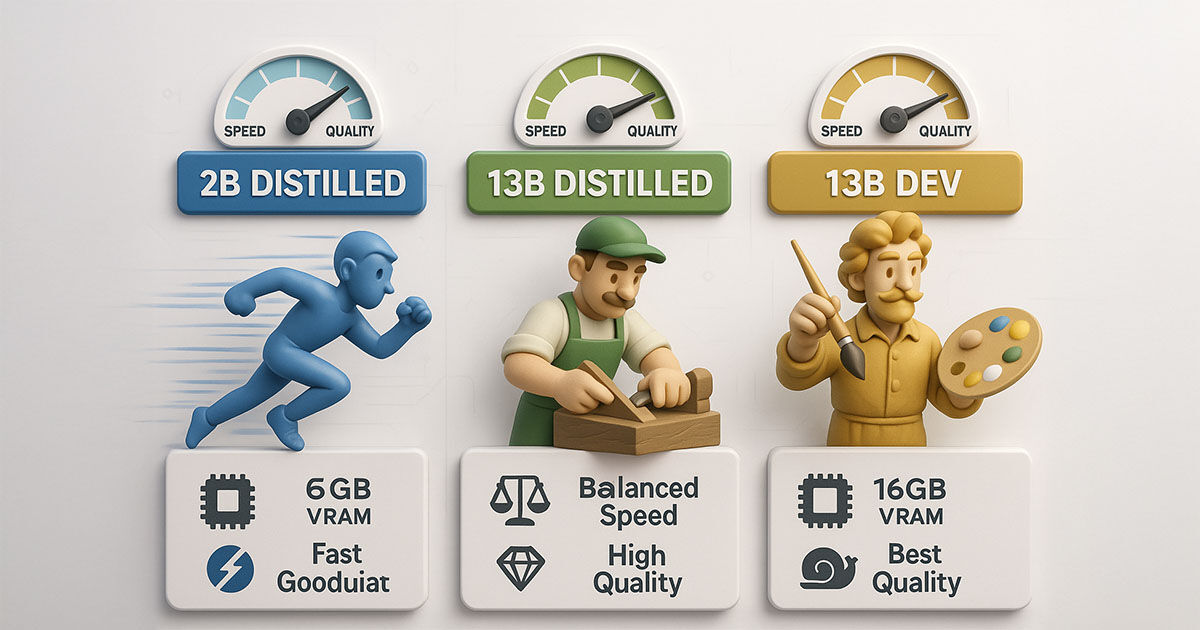

Lightricks nie poszedł na łatwiznę "jeden model dla wszystkich". Mamy kilka opcji:

LTX-V 13B 0.9.8 Dev - flagowiec. Najwyższa jakość, ale żre VRAM jak nie wiem co. 16GB to minimum dla komfortu.

LTX-V 13B 0.9.8 Distilled - kompromis. 15 razy szybszy od wersji dev, jakość... no, prawie tak dobra. Dla większości zastosowań w zupełności wystarczy.

LTX-V 2B 0.9.8 Distilled - dla oszczędnych. 6GB VRAM i działa. Jakość? Nie oszukujmy się, gorsza. Ale nadal użyteczna.

Są też wersje FP8 - skwantyzowane. Mniej pamięci, praktycznie ta sama jakość. Magia? Nie, dobra inżynieria.

Instalacja - bo bez tego nic się nie uda

ComfyUI Manager - dla leniwych (jak ja)

Najprostszy sposób? ComfyUI Manager. Wpisujesz "ComfyUI-LTXVideo", klikasz install, czekasz. Restart ComfyUI i gotowe.

Nie zawsze działa za pierwszym razem. Czasem trzeba ręcznie doinstalować zależności. Ale w 90% przypadków - bezproblemowo.

Instalacja manualna - dla kontrolfreków

bash

cd ComfyUI/custom_nodes

git clone https://github.com/Lightricks/ComfyUI-LTXVideo.git

cd ComfyUI-LTXVideo

pip install -r requirements.txt

Proste? Tak. Ale diabeł tkwi w szczegółach. Czasem pip nie znajdzie wszystkich pakietów. Czasem wersje się gryzą. Czasem... no, czasem trzeba pogrzebać.

Standalone - dla masochistów

bash

git clone https://github.com/Lightricks/LTX-Video.git

cd LTX-Video

python -m venv env

source env/bin/activate

python -m pip install -e .[inference]

Dlaczego masochistów? Bo potem trzeba wszystko samemu skonfigurować. Ale masz pełną kontrolę. Wybór należy do ciebie.

Pobieranie modeli - tu zaczyna się prawdziwa zabawa

Modele są duże. Bardzo duże. 13B dev to około 26GB. Na wolnym łączu to może być długa noc.

Gdzie je znaleźć? Hugging Face, repozytorium Lightricks. Ale uwaga - nie wszystkie wersje są tam dostępne jednocześnie. Czasem trzeba poczekać na aktualizację.

Enkoder tekstu T5XXL - obowiązkowy. Bez niego nic nie działa. t5xxl_fp16.safetensors do folderu models/clip/.

Główne modele do models/checkpoints/. Logiczne? Tak. Oczywiste? Nie zawsze.

Pierwsze kroki - workflow dla początkujących

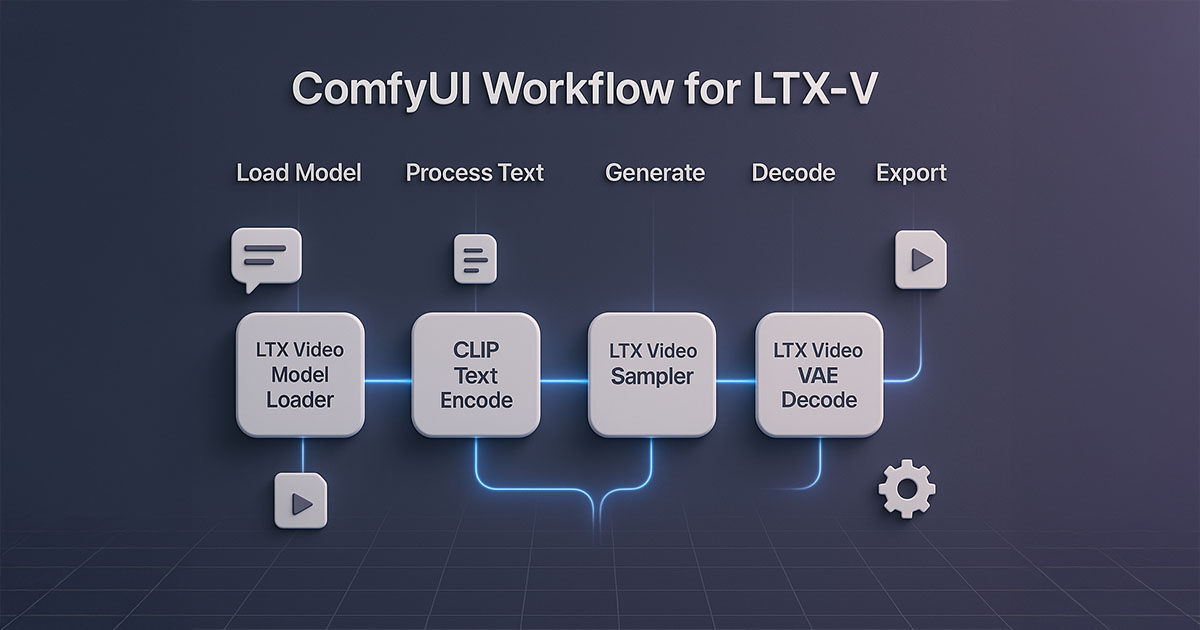

ComfyUI może przerażać. Węzły, połączenia, parametry... Ale spokojnie. Podstawowy workflow to pięć elementów:

- LTX Video Model Loader - ładuje model

- CLIP Text Encode - przetwarza prompt

- LTX Video Sampler - generuje

- LTX Video VAE Decode - dekoduje

- Video Combine - zapisuje

Połączasz je w tej kolejności. Działa? Powinno. Nie działa? Sprawdź ścieżki do modeli.

Parametry - sztuka kompromisu

CFG Scale - siła adherencji do promptu. 3-5 dla naturalności, 7-15 dla precyzji. Wyżej = więcej artefaktów.

Kroki próbkowania - jakość vs czas. Modele dev: 20-50 kroków. Distilled: 8-12 wystarcza.

Scheduler - DPM++ 2M Karras sprawdza się najlepiej. Ale eksperymentuj.

Nie ma uniwersalnych ustawień. To co działa dla jednego promptu, może nie działać dla innego.

Promptowanie - gdzie sztuka spotyka naukę

Anatomia dobrego promptu

Zacznij od akcji. Jednym zdaniem. "Kobieta tańczy na scenie."

Dodaj szczegóły ruchu. "Wykonuje powolne piruety, sukienka wiruje."

Opisz wygląd. Konkretnie. "Długie kasztanowe włosy, czerwona jedwabna sukienka."

Środowisko i atmosfera. "Słabo oświetlona scena teatralna, pojedynczy reflektor."

Kamera i oświetlenie. "Kamera powoli się zbliża, ciepłe światło."

Przykład promptu, który działa

"A weathered fisherman in his sixties casts his net from a small wooden boat at dawn. His movements are deliberate and practiced, arms extending in a wide arc as the net unfurls over the calm water. He wears a faded blue sweater and yellow rain boots, his gray beard catching the golden morning light. The boat gently rocks on the mirror-like surface of a misty lake surrounded by pine trees. The camera captures this from a low angle, emphasizing the fisherman's silhouette against the pastel sky."

Długi? Tak. Szczegółowy? Bardzo. Skuteczny? Sprawdź sam.

Negatywne prompty - równie ważne

"static image, no movement, frozen, blurry, low quality, distorted faces, extra limbs, watermark, logo, text overlay, compression artifacts, flickering, inconsistent lighting"

Brzmi jak lista problemów? Bo nią jest. LTX-V ma swoje słabości. Lepiej je od razu wykluczyć.

Problemy i rozwiązania - bo nie zawsze idzie gładko

CUDA Out of Memory

Najczęstszy problem. Rozwiązania: - Mniejszy model (2B zamiast 13B) - Niższa rozdzielczość (768×512) - Krótsza sekwencja (24 klatki zamiast 60) - Model offloading (wolniej, ale działa)

Brak ruchu w wideo

Często problem z obrazami wejściowymi. Zbyt ostre, "czyste" zdjęcia model interpretuje jako statyczne.

Rozwiązanie? Lekka kompresja JPEG. Subtelne rozmycie. Dodanie szumu. Brzmi dziwnie, ale działa.

Artefakty wizualne

Migotanie, morfowanie, niemożliwe fizycznie ruchy. Zmniejsz CFG Scale. Zwiększ kroki próbkowania. Zmień scheduler.

Nie ma uniwersalnej recepty. Trzeba eksperymentować.

Zaawansowane techniki - dla ambitnych

Keyframes - precyzyjna kontrola

Definiujesz kluczowe momenty. Model interpoluje między nimi. Brzmi prosto? W teorii tak.

W praktyce wymaga cierpliwości i eksperymentowania. Ale efekty mogą być spektakularne.

Rozszerzanie sekwencji

Forward extension - kontynuacja akcji. Backward extension - "prehistoria" wydarzeń.

Działa? Czasem bardzo dobrze. Czasem... no, czasem lepiej zacząć od nowa.

Multi-scale rendering

Szybka generacja niskiej jakości + upscaling wysokiej jakości. Najlepsze z dwóch światów?

Może. Ale workflow staje się skomplikowany. Nie dla każdego.

Praktyczne zastosowania - gdzie LTX-V się sprawdza

Social media

Instagram Reels, TikTok - idealne zastosowanie. 15-60 sekund, dynamiczne treści. LTX-V w swoim żywiole.

Kampanie produktowe? Sprawdza się. Zamiast kosztownej sesji - animacja zdjęć produktów. Szybko, tanio, efektownie.

Edukacja

Wizualizacja abstrakcyjnych konceptów. Fizyka kwantowa? Mechanika płynów? Historia? LTX-V potrafi to "pokazać".

Nie zastąpi dobrego nauczyciela. Ale może mu pomóc.

Prototypowanie filmowe

Pre-visualization bez kosztów studia. Testowanie koncepcji. Komunikacja z klientem.

Nie zastąpi prawdziwych zdjęć. Ale może zaoszczędzić czas i pieniądze na etapie planowania.

Sztuka cyfrowa

Nowe medium ekspresji. Generative art z wymiarem czasowym. Instalacje interaktywne.

Czy to jeszcze sztuka? Filozoficzny spór na inną okazję.

Przyszłość - dokąd zmierzamy?

Lightricks nie śpi. Roadmapa na 2025 obejmuje: - Dłuższe sekwencje (kilka minut) - Lepszą spójność czasową - Integrację z audio - Real-time generation

Brzmi ambitnie? Tak. Realistycznie? Zobaczymy.

Wyzwania etyczne

Deepfakes. Dezinformacja. Prawa autorskie. Zastąpienie ludzkiej pracy.

Nie ma prostych odpowiedzi. Technologia rozwija się szybciej niż prawo i etyka.

Podsumowanie - czy warto?

LTX-V to solidne narzędzie. Nie idealne, ale użyteczne. Szybkie, dostępne, wszechstronne.

Czy zmieni wszystko? Prawdopodobnie nie. Czy może być przydatne? Zdecydowanie tak.

Dla kogo? Twórców treści, edukatorów, prototypowców, artystów. Każdego, kto potrzebuje szybko stworzyć wideo bez budżetu na studio.

Czy zastąpi profesjonalną produkcję? Nie. Czy może ją uzupełnić? Bez wątpienia.

Przyszłość tworzenia treści wideo już tu jest. Nazywa się LTX-V. I nie, nie jest idealna. Ale jest dostępna. Już dziś.

Przypisy i źródła

[1] Lightricks Official Documentation - https://www.lightricks.com/ltxv-documentation

[2] ComfyUI-LTXVideo GitHub Repository - https://github.com/Lightricks/ComfyUI-LTXVideo/

[3] Civitai LTX-V Guide - https://education.civitai.com/civitais-quickstart-guide-to-lightricks-ltxv/

Często zadawane pytania

Czy LTX-V jest darmowy?

Tak, model jest open source. Potrzebujesz tylko odpowiedniego sprzętu.

Jakie są minimalne wymagania sprzętowe?

8GB VRAM dla podstawowej wersji. 16GB dla komfortowej pracy z pełnym modelem.

Czy można używać komercyjnie?

Tak, licencja OpenRail-M pozwala na komercyjne wykorzystanie.

Jak długie wideo można wygenerować?

Najnowsza wersja obsługuje do 60 sekund. Dłuższe sekwencje można tworzyć poprzez łączenie segmentów.

Czy LTX-V działa na macOS?

Tak, obsługuje chipy Apple Silicon z PyTorch 2.3.0+.

Chcesz być na bieżąco z najnowszymi trendami w AI? Śledź nasz blog i nie przegap kolejnych artykułów o przełomowych technologiach!

.jpg)