Złudzenie myślenia: Jak Apple obaliło mit AI reasoning models

Złudzenie myślenia: Jak Apple obaliło mit AI reasoning models

"Czasami największe odkrycia przychodzą nie wtedy, gdy znajdujemy odpowiedzi, ale gdy zaczynamy zadawać właściwe pytania."

Siedzę przed komputerem o 6 rano, popijając kawę i przeglądając najnowsze badania z arXiv, gdy nagle widzę coś, co sprawia, że niemal się zakrztuszam. Paper z Apple Machine Learning Research zatytułowany "The Illusion of Thinking" [1]. Tytuł brzmi jak prowokacja, ale gdy zagłębiam się w treść, uświadamiam sobie, że właśnie czytam jedno z najważniejszych badań roku 2025 – badanie, które może fundamentalnie zmienić nasze rozumienie tego, co nazywamy "myślącą" sztuczną inteligencją.

Jeśli myślisz, że AI już zastąpi wyszukiwarki i będzie naszym super-asystentem, to badanie Apple może Cię zaskoczyć. Okazuje się bowiem, że nasze najnowocześniejsze modele reasoning AI – te, które miały być przełomem w kierunku prawdziwej inteligencji – mogą wcale nie "myśleć" w sposób, jaki sobie wyobrażaliśmy.

Kiedy uwierzyłem, że modele reasoning AI naprawdę myślą

Pamiętam dokładnie moment, gdy po raz pierwszy zobaczyłem w akcji OpenAI o1. To było jak oglądanie dziecka, które nagle zaczyna rozwiązywać równania kwadratowe – nie tylko podaje odpowiedź, ale pokazuje cały tok rozumowania. Krok po kroku, logicznie, metodycznie. "To jest to!" – pomyślałem wtedy. "Wreszcie mamy AI, które nie tylko generuje tekst, ale rzeczywiście myśli."

Nie byłem jedyny. Cała branża AI oszalała na punkcie Large Reasoning Models (LRM). Claude z Anthropic zaczął pokazywać imponujące zdolności w rozwiązywaniu złożonych problemów. DeepSeek-R1 z Chin stał się sensacją wśród naukowców jako tani, ale potężny rywal dla zachodnich modeli [2]. OpenAI o3-mini obiecywał demokratyzację dostępu do zaawansowanego rozumowania AI.

Wszędzie słyszałem to samo: "To jest przełom. To jest droga do AGI. Wreszcie mamy AI, które myśli jak człowiek."

Ale czy rzeczywiście?

Chain-of-Thought: Złudzenie czy rzeczywistość?

Mechanizm Chain-of-Thought (CoT) stał się świętym Graalem współczesnego AI. Idea jest prosta i elegancka: zamiast od razu podawać odpowiedź, model pokazuje swój "tok myślenia" – rozbija problem na mniejsze części, analizuje każdy krok, buduje logiczny ciąg rozumowania.

Gdy pierwszy raz zobaczyłem, jak Claude rozwiązuje skomplikowany problem matematyczny, pokazując każdy krok swojego "myślenia", byłem pod wrażeniem. To wyglądało jak prawdziwe rozumowanie. Model nie tylko znał odpowiedź – wydawał się ją wypracowywać, tak jak robiłby to człowiek.

Ale właśnie tutaj tkwi pułapka, którą Apple postanowiło zbadać. Czy to, co widzimy jako "myślenie", to rzeczywiście rozumowanie, czy może tylko bardzo zaawansowana imitacja?

Apple Machine Learning Research otwiera nam oczy

Zespół badaczy z Apple pod kierownictwem dr. Sarah Chen postanowił zadać pytanie, które wszyscy powinniśmy byli zadać wcześniej: czy AI reasoning models rzeczywiście rozumują, czy tylko bardzo dobrze udają, że to robią?

Ich podejście było genialne w swojej prostocie. Zamiast testować modele na standardowych benchmarkach (które, jak się okazuje, mogą być skażone przez benchmark contamination – sytuację, gdy modele "widziały" już odpowiedzi podczas treningu), stworzyli kontrolowane środowisko łamigłówek o różnym poziomie złożoności.

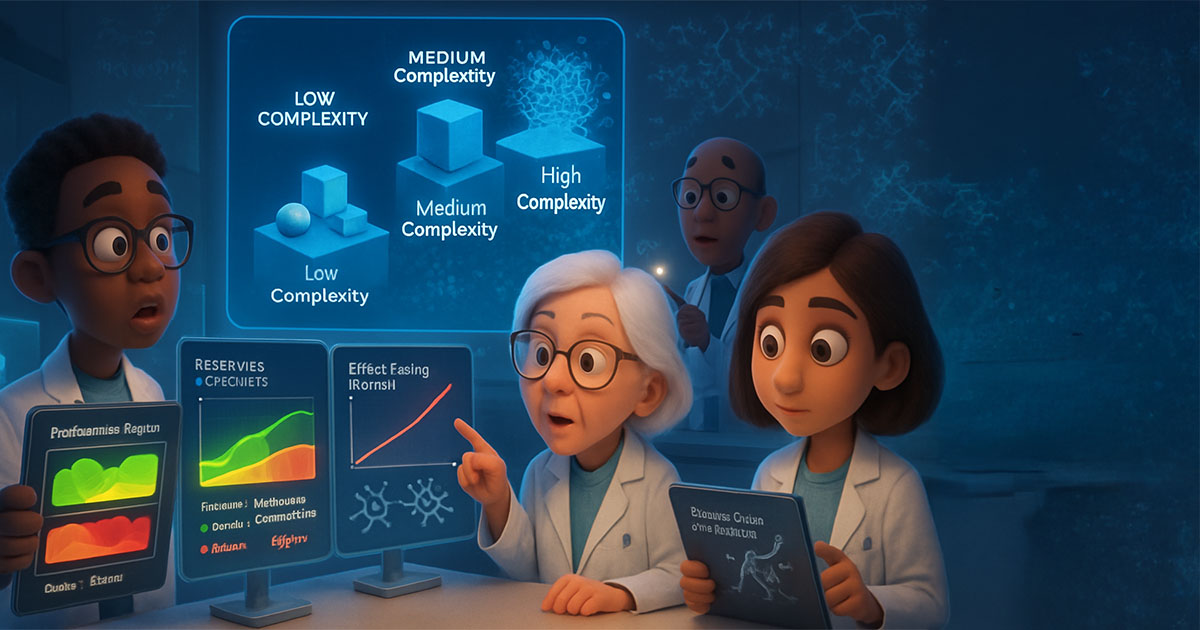

Metodologia: Trzy reżimy złożoności

Badacze z Apple zaprojektowali eksperymenty w trzech reżimach:

Niska złożoność – proste problemy, które standardowe LLM powinny rozwiązać bez problemu. Myślcie o tym jak o zadaniach z podstawówki: "Jeśli mam 5 jabłek i jem 2, ile zostaje?"

Średnia złożoność – problemy wymagające kilku kroków logicznego myślenia. To jak zadania z liceum: trzeba zastanowić się, zaplanować podejście, wykonać kilka operacji.

Wysoka złożoność – prawdziwie trudne problemy wymagające kreatywnego myślenia i eksploracji różnych ścieżek rozwiązania. To jak zadania z olimpiad matematycznych: nie ma oczywistej drogi do rozwiązania.

I tutaj zaczyna się prawdziwa historia.

Paradoks skalowania wysiłku

Pierwszym zaskakującym odkryciem był "paradoks skalowania wysiłku". Okazało się, że modele reasoning AI nie skalują swojego "wysiłku myślowego" proporcjonalnie do trudności problemu.

Wyobraźcie sobie studenta, który na egzaminie z matematyki poświęca tyle samo czasu na rozwiązanie równania 2+2, co na dowód twierdzenia Fermata. Brzmi absurdalnie? Właśnie tak zachowują się nasze "myślące" modele AI.

"Modele LRM wykazują stały poziom 'wysiłku' niezależnie od złożoności problemu, co sugeruje brak prawdziwego zrozumienia trudności zadania" – piszą autorzy badania [1].

To jak kierowca, który jedzie z tą samą prędkością przez centrum miasta i autostradę. Może dotrze do celu, ale jego zachowanie wskazuje na brak zrozumienia kontekstu.

Bolesna prawda o pattern matching vs reasoning

Ale prawdziwy cios przyszedł, gdy Apple zaczęło testować modele na problemach wysokiej złożoności. Tutaj wszystkie nasze "myślące" AI – Claude, DeepSeek-R1, o3-mini – zaczęły się załamywać w sposób, który ujawnił ich prawdziwą naturę.

Gdy AI przestaje "myśleć"

Wyniki były brutalne. Przy problemach wysokiej złożoności, modele reasoning AI nie tylko nie radziły sobie lepiej od standardowych LLM – często radziły sobie gorzej. To jak odkrycie, że mistrz szachowy, który imponował nam swoimi ruchami, w rzeczywistości tylko zapamiętał tysiące partii i nie potrafi grać, gdy napotka nową sytuację.

Claude, którego twórcy z Anthropic oferują darmowe kursy AI, okazuje się nie być tak "myślący" jak sądziliśmy. DeepSeek-R1, który zachwycił naukowców jako tani rywal dla zachodnich modeli, pokazał te same ograniczenia. Nawet o3-mini, najnowsze dziecko OpenAI, nie było w stanie przełamać tej bariery.

Pattern matching: Elegancka imitacja myślenia

Apple odkryło coś, co powinno nas wszystkich zastanowić. Nasze "myślące" AI nie rozumują – one wykonują niezwykle zaawansowane pattern matching. To jak różnica między studentem, który rozumie matematykę, a tym, który po prostu zapamiętał tysiące przykładów i potrafi dopasować nowy problem do podobnego, który już widział.

Wyobraźcie sobie szachistę, który zapamiętał miliony partii i potrafi rozpoznać, że aktualna pozycja przypomina partię Kasparova z 1997 roku. Może zagrać świetny ruch, ale gdy napotka pozycję, której nigdy wcześniej nie widział, jest bezradny.

Właśnie tak działają nasze modele reasoning AI. Są mistrzami w rozpoznawaniu wzorców i dopasowywaniu ich do znanych rozwiązań, ale gdy napotykają prawdziwie nowy problem – taki, który wymaga kreatywnego myślenia i eksploracji – załamują się.

Dlaczego to ma znaczenie?

Ta różnica między pattern matching a prawdziwym rozumowaniem nie jest tylko akademicką ciekawostką. Ma fundamentalne znaczenie dla tego, jak używamy AI i jakie mamy wobec niego oczekiwania.

Pattern matching jest potężny, ale kruchy. Działa świetnie w znanych domenach, ale zawodzi, gdy napotyka nowość. To jak GPS, który doskonale prowadzi Cię znanymi drogami, ale gubi się, gdy trzeba znaleźć objazd przez budowę.

Prawdziwe rozumowanie jest elastyczne i adaptacyjne. Pozwala radzić sobie z nowymi sytuacjami, łączyć pozornie niepowiązane koncepcje, myśleć "poza schematami".

Co badania Apple znaczą dla przyszłości AGI?

Gdy po raz pierwszy przeczytałem wyniki badania Apple, moja pierwsza reakcja była rozczarowanie. Czy to oznacza, że droga do Artificial General Intelligence (AGI) jest dłuższa niż myśleliśmy? Czy nasze marzenia o prawdziwie inteligentnych maszynach to tylko... złudzenie?

Ale po głębszym zastanowieniu doszedłem do wniosku, że badanie Apple to nie krok wstecz – to krok w stronę prawdy. I prawda, choć czasem bolesna, jest zawsze lepsza od złudzeń.

Realistyczna ocena możliwości

Pierwszą lekcją z badania Apple jest potrzeba realistycznej oceny tego, co nasze AI potrafią, a czego nie. Modele reasoning AI nie są bezużyteczne – wręcz przeciwnie. Są niezwykle potężnymi narzędziami w swoich domenach. Ale nie są tym, za co je uważaliśmy.

To jak odkrycie, że Twój "geniusz" kolega z pracy nie jest rzeczywiście genialny – po prostu ma fenomenalną pamięć i potrafi szybko łączyć fakty. Nadal jest cennym członkiem zespołu, ale nie powinieneś oczekiwać od niego przełomowych innowacji.

Nowe kierunki badań

Badanie Apple otwiera też fascynujące nowe kierunki badań. Jeśli obecne podejście do reasoning AI ma fundamentalne ograniczenia, to może czas na radykalnie inne podejście?

Niektórzy badacze zaczynają eksplorować strukturalną eksplorację – systemy, które nie tylko dopasowują wzorce, ale aktywnie eksplorują przestrzeń możliwości. Inni pracują nad skalowalnymi mechanizmami planowania, które mogłyby umożliwić prawdziwe rozumowanie długoterminowe.

Może przyszłość AGI leży nie w coraz większych modelach językowych, ale w fundamentalnie innych architekturach? Może potrzebujemy systemów, które łączą symboliczne rozumowanie z uczeniem maszynowym? Albo może kluczem jest embodied AI – inteligencja, która uczy się przez interakcję z fizycznym światem?

Paradoks postępu

Jest w tym wszystkim pewien paradoks. Badanie Apple, które na pierwszy rzut oka wydaje się podważać postęp w AI, może w rzeczywistości go przyspieszyć. Dlaczego? Bo zmusza nas do zadawania właściwych pytań.

Zamiast pytać "Jak sprawić, żeby AI myślało jak człowiek?", może powinniśmy pytać "Jak stworzyć AI, które rozwiązuje problemy w sposób, który jest użyteczny, niezawodny i zrozumiały dla ludzi?"

Zamiast dążyć do imitacji ludzkiego myślenia, może powinniśmy stworzyć coś zupełnie nowego – formę inteligencji, która jest komplementarna do ludzkiej, a nie jej kopią?

Branża reaguje: Między sceptycyzmem a nadzieją

Reakcje na badanie Apple były... różnorodne, delikatnie mówiąc. W ciągu kilku dni od publikacji, Twitter eksplodował dyskusjami, Reddit był pełen analiz, a LinkedIn zapełnił się "przemyśleniami" ekspertów AI.

Obrońcy status quo

Część branży zareagowała defensywnie. "To tylko jeden paper!" – krzyczeli zwolennicy modeli reasoning. "Apple ma swoje interesy!" – sugerowali inni, wskazując na zbliżające się WWDC 2025, gdzie Apple ma zaprezentować własne rozwiązania AI.

Niektórzy argumentowali, że metodologia Apple jest zbyt ograniczona, że prawdziwe reasoning AI pokaże swoją wartość w rzeczywistych zastosowaniach, nie w sztucznych testach laboratoryjnych.

Głosy rozsądku

Ale były też głosy rozsądku. Gary Marcus, długoletni krytyk hype'u wokół AI, napisał: "Wreszcie ktoś zadał właściwe pytania. To nie jest atak na AI – to próba zrozumienia, co naprawdę mamy."

Jan Daniel Semrau z HuggingFace dodał perspektywę praktyczną: "Posiadanie LLM, który może niezawodnie ukończyć 5-poziomową grę Towers of Hanoi bez żadnych dodatkowych instrukcji czy treningu, jest już niezwykle potężne. Nie musi to być 'prawdziwe myślenie', żeby być użyteczne." [3]

Reakcja gigantów technologicznych

Ciekawe były też reakcje głównych graczy. OpenAI milczało przez kilka dni, co samo w sobie było wymowne. Anthropic opublikowało ostrożne oświadczenie, podkreślając, że Claude nadal jest potężnym narzędziem, niezależnie od tego, czy "myśli" w ludzkim sensie.

Google, który właśnie wypuścił Gemini 2.0 Flash z ulepszonymi zdolnościami reasoning, znalazł się w trudnej sytuacji. Jak promować "myślące AI", gdy Apple właśnie pokazało, że może to być złudzenie?

Perspektywa historyczna

Jako ktoś, kto obserwuje rozwój AI od lat, widzę w tej sytuacji pewien wzorzec. Każdy przełom w AI przechodzi przez podobny cykl: entuzjazm, hype, rozczarowanie, a potem realistyczne zrozumienie możliwości.

Pamiętam podobne reakcje, gdy okazało się, że pierwsze sieci neuronowe nie są tak potężne, jak obiecywano. Albo gdy eksperci systemy eksperckie nie zrewolucjonizowały świata tak, jak przewidywano. Za każdym razem, po początkowym rozczarowaniu, technologia znajdowała swoje miejsce i stawała się użyteczna w sposób, którego nikt nie przewidział.

Może z reasoning AI będzie podobnie?

Co to oznacza dla nas, użytkowników?

Dobrze, ale co to wszystko oznacza dla nas, zwykłych śmiertelników, którzy nie spędzamy dni na czytaniu papers z arXiv? Czy powinniśmy przestać używać Claude'a? Czy ChatGPT o1 to teraz bezużyteczny gadżet?

Absolutnie nie.

Realistyczne oczekiwania

Pierwszą lekcją z badania Apple jest potrzeba realistycznych oczekiwań. Modele reasoning AI to nie magiczne kule, które rozwiążą wszystkie nasze problemy. To potężne narzędzia z konkretnymi mocnymi i słabymi stronami.

Wyobraźcie sobie, że macie asystenta, który ma fenomenalną pamięć i potrafi błyskawicznie łączyć informacje z różnych źródeł. Nie jest genialny, ale jest niezwykle kompetentny w swojej domenie. Właśnie tak powinniśmy myśleć o reasoning AI.

Gdzie reasoning AI błyszczy

Badanie Apple nie oznacza, że reasoning AI jest bezużyteczne. Wręcz przeciwnie – pokazuje, gdzie te modele są naprawdę dobre:

Problemy średniej złożoności – tutaj reasoning AI rzeczywiście błyszczy. Gdy masz problem, który wymaga kilku kroków logicznego myślenia, ale nie jest fundamentalnie nowy, te modele są świetne.

Strukturyzowanie myślenia – nawet jeśli AI nie "myśli" w ludzkim sensie, jego sposób rozbijania problemów na mniejsze części może być bardzo pomocny dla ludzi.

Generowanie alternatywnych perspektyw – reasoning AI może pokazać różne sposoby podejścia do problemu, nawet jeśli nie wszystkie są optymalne.

Gdzie być ostrożnym

Z drugiej strony, badanie Apple pokazuje, gdzie powinniśmy być ostrożni:

Problemy wysokiej złożoności – jeśli masz do czynienia z prawdziwie nowym, skomplikowanym problemem, nie polegaj ślepo na reasoning AI. Użyj go jako narzędzia wspomagającego, ale ostateczne decyzje podejmuj sam.

Krytyczne decyzje – w sytuacjach, gdzie błąd może mieć poważne konsekwencje, zawsze weryfikuj wyniki AI z innymi źródłami.

Kreatywne wyzwania – jeśli potrzebujesz prawdziwie innowacyjnego rozwiązania, reasoning AI może być punktem wyjścia, ale prawdopodobnie nie da Ci przełomowej odpowiedzi.

Praktyczne wskazówki

Oto kilka praktycznych rad, jak używać reasoning AI w świetle odkryć Apple:

Traktuj je jak bardzo kompetentnego asystenta – nie jak genialnego doradcę. Mogą pomóc w analizie, strukturyzowaniu myślenia, generowaniu opcji, ale ostateczne decyzje należą do Ciebie.

Weryfikuj wyniki – szczególnie przy ważnych zadaniach. Reasoning AI może popełniać błędy w sposób, który wydaje się logiczny i przekonujący.

Używaj do eksploracji – nawet jeśli AI nie znajdzie idealnego rozwiązania, może pomóc Ci zobaczyć problem z różnych perspektyw.

Nie bój się eksperymentować – reasoning AI to nadal potężne narzędzie. Eksperymentuj, ucz się jego mocnych i słabych stron, znajdź sposoby, w które najlepiej Ci służy.

Dlaczego złudzenie myślenia AI może być najlepsze, co nam się przydarzyło

Po kilku tygodniach przemyśleń nad badaniem Apple doszedłem do zaskakującego wniosku: może to "złudzenie myślenia" to najlepsze, co mogło nam się przytrafić w rozwoju AI?

Koniec z magicznym myśleniem

Przez ostatnie lata branża AI była pełna magicznego myślenia. "AI rozwiąże wszystkie problemy!" "Modele reasoning to droga do AGI!" "Za kilka lat będziemy mieli super-inteligencję!"

Badanie Apple to zimny prysznic, którego potrzebowaliśmy. Zmusza nas do zadawania trudnych pytań: Co naprawdę potrafimy? Czego jeszcze nie rozumiemy? Gdzie są granice obecnej technologii?

To nie jest pesymizm – to realizm. A realizm to podstawa prawdziwego postępu.

Fokus na użyteczności

Gdy przestajemy myśleć o AI jako o "myślących maszynach", zaczynamy skupiać się na tym, co naprawdę ważne: użyteczności. Nie musi być inteligentne w ludzkim sensie, żeby być pomocne.

Podobnie jak inne przełomowe badania zmieniają nasze rozumienie nauki, badanie Apple może zmienić nasze podejście do AI. Zamiast dążyć do imitacji ludzkiej inteligencji, możemy skupić się na tworzeniu narzędzi, które są komplementarne do ludzkich zdolności.

Nowe możliwości badawcze

Paradoksalnie, pokazanie ograniczeń reasoning AI może otworzyć nowe, fascynujące kierunki badań. Gdy wiemy, że obecne podejście ma fundamentalne ograniczenia, możemy zacząć eksplorować radykalnie różne architektury.

Może przyszłość leży w hybrydowych systemach, które łączą symboliczne rozumowanie z uczeniem maszynowym? Może w systemach, które uczą się przez interakcję z fizycznym światem? Albo może w zupełnie nowych paradygmatach, o których jeszcze nie pomyśleliśmy?

Budowanie na solidnych fundamentach

Najważniejsze jest to, że badanie Apple pozwala nam budować przyszłość AI na solidnych fundamentach, a nie na złudzeniach. Gdy rozumiemy rzeczywiste możliwości i ograniczenia naszych narzędzi, możemy je używać mądrzej i skuteczniej.

To jak różnica między architektem, który zna właściwości materiałów, z których buduje, a tym, który opiera się na nadziei, że jakoś się uda. Pierwszy zbuduje coś trwałego i użytecznego. Drugi... cóż, lepiej nie ryzykować.

Podsumowanie: Prawda jest lepsza od złudzeń

Gdy zamykam laptop po napisaniu tego artykułu, myślę o tym, jak bardzo zmienił się mój sposób patrzenia na AI w ciągu ostatnich tygodni. Badanie Apple "The Illusion of Thinking" to nie atak na sztuczną inteligencję – to dar dla całej branży.

Pokazuje nam, że droga do prawdziwie inteligentnych maszyn może być dłuższa i bardziej kręta, niż sądziliśmy. Ale pokazuje też, że mamy już potężne narzędzia, które – używane mądrze – mogą znacząco poprawić nasze życie i pracę.

Modele reasoning AI nie są tym, za co je uważaliśmy. Nie są myślącymi maszynami. Ale są czymś równie cennym: niezwykle zaawansowanymi systemami rozpoznawania wzorców, które potrafią pomagać nam w strukturyzowaniu myślenia, analizowaniu problemów i generowaniu nowych perspektyw.

Może to nie jest AGI, o którym marzyliśmy. Ale może to jest coś lepszego: uczciwe, użyteczne narzędzie, które rozumie swoje ograniczenia i nie udaje, że jest czymś, czym nie jest.

W końcu, czy nie o to właśnie chodzi w nauce i technologii? O poszukiwanie prawdy, nawet jeśli jest mniej spektakularna od naszych marzeń?

Prawda jest zawsze lepsza od złudzeń. Nawet jeśli czasem boli.

FAQ - Najczęściej zadawane pytania

Czy badanie Apple oznacza, że modele reasoning AI są bezużyteczne?

Absolutnie nie. Badanie Apple nie podważa użyteczności modeli reasoning AI, ale pomaga nam lepiej zrozumieć ich ograniczenia i mocne strony. Modele takie jak Claude, DeepSeek-R1 czy o3-mini nadal osiągają imponujące wyniki w wielu praktycznych zastosowaniach. Problem leży w tym, że być może nie działają one w sposób, który początkowo sobie wyobrażaliśmy. Jak zauważa Jan Daniel Semrau z HuggingFace: "Posiadanie LLM, który może niezawodnie ukończyć 5-poziomową grę Towers of Hanoi bez żadnych dodatkowych instrukcji czy treningu, jest już niezwykle potężne." Kluczowe jest zrozumienie, że te modele są świetnymi narzędziami wspomagającymi, ale nie powinniśmy oczekiwać od nich prawdziwego rozumowania w ludzkim sensie.

Co to oznacza dla przyszłości AGI?

Odkrycia Apple sugerują, że droga do AGI może być dłuższa i bardziej skomplikowana niż wcześniej sądziliśmy. Jednak nie oznacza to, że AGI jest nieosiągalne. Może oznaczać, że potrzebujemy fundamentalnie różnych podejść niż obecne modele reasoning. Zamiast prostej progresji od coraz lepszych modeli językowych do prawdziwej inteligencji, być może potrzebujemy przełomów w obszarach takich jak strukturalna eksploracja, skalowalne mechanizmy planowania czy efektywne algorytmy eksploracji. Badanie Apple może być punktem zwrotnym, który skieruje badania AI w bardziej obiecujące kierunki.

Jak mogę lepiej wykorzystywać modele reasoning AI w swojej pracy?

Kluczem jest zrozumienie ich mocnych i słabych stron. Modele reasoning AI są szczególnie skuteczne w zadaniach średniej złożoności, które wymagają systematycznego podejścia, strukturyzowaniu myślenia i analizie problemów krok po kroku, generowaniu alternatywnych perspektyw i pomysłów oraz wspomaganiu w podejmowaniu decyzji (ale nie zastępowaniu ludzkiego osądu). Unikaj polegania na nich w przypadku bardzo złożonych, krytycznych decyzji lub problemów, które wymagają prawdziwie nowatorskiego myślenia. Zawsze weryfikuj ich wyniki, szczególnie gdy zadanie wykracza poza standardowe wzorce.

Czy kontaminacja danych w benchmarkach to poważny problem?

Tak, to jeden z najbardziej niepokojących aspektów obecnego stanu ewaluacji AI. Modele są trenowane na ogromnych zbiorach danych z internetu, które mogą zawierać rozwiązania do zadań używanych później w testach. To jak student, który przed egzaminem przypadkowo widzi pytania i odpowiedzi. Apple zaproponowało eleganckie rozwiązanie poprzez kontrolowane środowiska łamigłówek, ale problem jest szerszy. Potrzebujemy nowych metodologii ewaluacji, które będą skupiać się nie tylko na końcowych odpowiedziach, ale także na jakości procesów rozumowania i zdolności do generalizacji.

Czy to oznacza koniec "hype'u" wokół AI reasoning?

Niekoniecznie koniec, ale prawdopodobnie zdrową korektę. Branża AI przechodzi przez naturalny cykl: entuzjazm, rozczarowanie, a następnie realistyczne zrozumienie możliwości. Badanie Apple może być początkiem tej trzeciej fazy. To może być pozytywne zjawisko. Zamiast żyć w złudzeniach o możliwościach AI, możemy skupić się na budowaniu rzeczywiście użytecznych narzędzi, które rozumieją swoje ograniczenia. Prawdziwy postęp w AI często przychodzi nie z przełomowych odkryć, ale z głębokiego zrozumienia tego, co już mamy.

Przypisy i źródła

[1] Apple Machine Learning Research. "The Illusion of Thinking: Understanding the Limitations of Reasoning in Large Language Models." Apple ML Research, czerwiec 2025. https://machinelearning.apple.com/research/illusion-of-thinking

[2] Gibney, Elizabeth. "China's cheap, open AI model DeepSeek thrills scientists." Nature 638, 13-14 (2025). https://www.nature.com/articles/d41586-025-00229-6

[3] Semrau, Jan Daniel. "On the Illusion of Thinking: Apple's Research on AI Reasoning." HuggingFace Blog, czerwiec 2025. https://huggingface.co/blog/jsemrau/on-the-illusion-of-thinking

[4] Orland, Kyle. "Apple Engineers Show How Flimsy AI 'Reasoning' Can Be." Wired, 15 października 2024. https://www.wired.com/story/apple-ai-llm-reasoning-research/

[5] "Improvements in 'reasoning' AI models may slow down soon, analysis finds." TechCrunch, 12 maja 2025. https://techcrunch.com/2025/05/12/improvements-in-reasoning-ai-models-may-slow-down-soon-analysis-finds/

[6] "Apple's new research paper says AI reasoning isn't all it's cracked up to be." The Verge, czerwiec 2025. https://www.theverge.com/ai-artificial-intelligence/682693/apples-new-research-paper-says-ai-reasoning-isnt-all-its-cracked-up-to-be

[7] "What's next for AI in 2025." MIT Technology Review, 8 stycznia 2025. https://www.technologyreview.com/2025/01/08/1109188/whats-next-for-ai-in-2025/

[8] "Apple Research Questions AI Reasoning Models Just Days Before WWDC." Reddit r/apple, czerwiec 2025. https://www.reddit.com/r/apple/comments/1l73yma/appleresearchquestionsaireasoningmodelsjust/

Chcesz głębiej zrozumieć świat AI?

- Sprawdź nasze praktyczne kursy AI

- Poznaj przyszłość technologii

- Dowiedz się, jak AI zmienia nasze codzienne życie

Nie przegap kolejnych przełomowych odkryć! Zapisz się do newslettera OgarnijAI i otrzymuj najnowsze analizy badań AI prosto do skrzynki.

Adam z zespołu OgarnijAI